深度学习的世界里,模型的性能往往取决于无数个细节,而超参数的设置无疑是其中最为关键的一环。超参数,这些在训练开始之前就需要设定的参数,就像是深度学习模型的“基因”,决定了模型的结构、学习速率以及优化方向。

超参数的选择不仅影响模型的收敛速度,更决定了模型的最终性能。然而,超参数的设置并非一成不变,它需要根据具体问题和数据进行调整,这使得超参数优化成为深度学习中最具挑战性的任务之一。

这篇文章中,我们将深入探讨深度学习中超参数的种类、作用以及优化策略。

01

什么是超参数?

/ Deep Learning

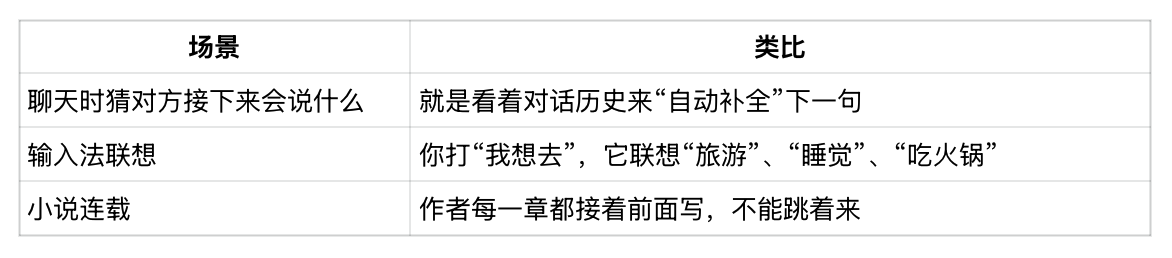

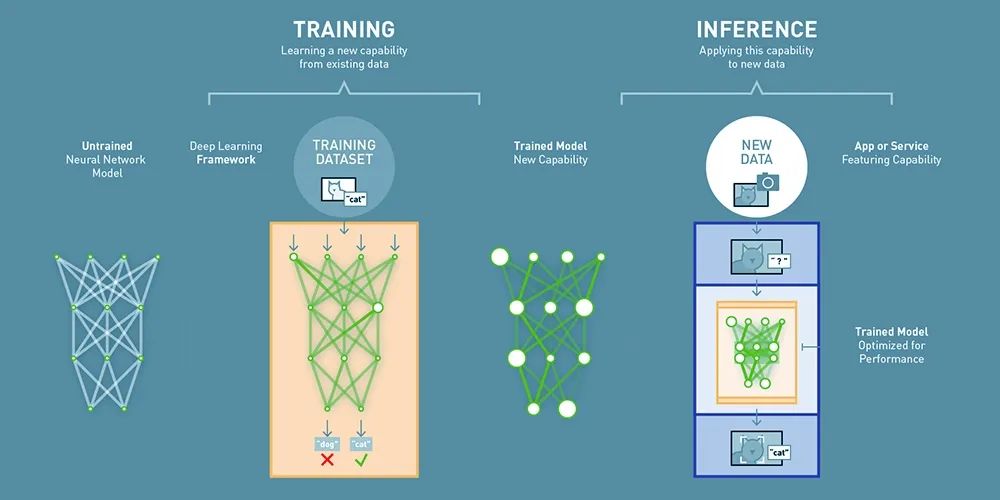

在深度学习中,超参数是指在模型训练开始之前需要手动设置的参数。

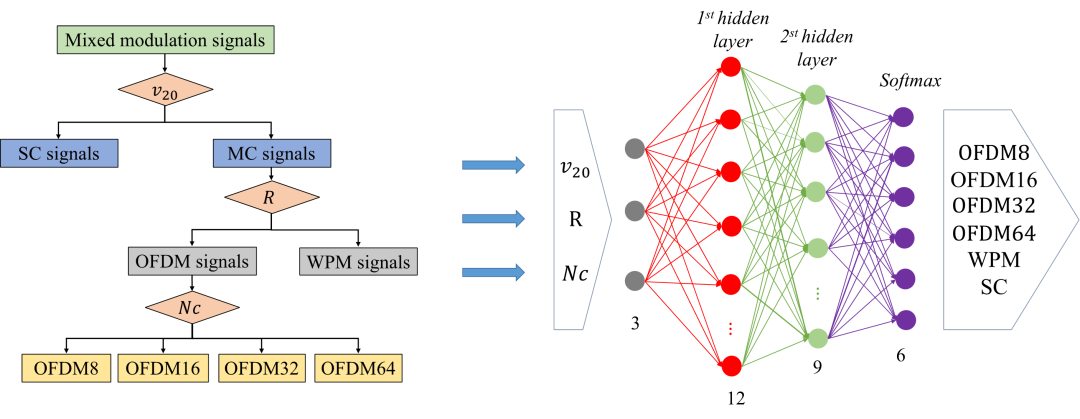

▲ 神经网络应用案例

与模型参数(如神经网络中的权重和偏置)不同,超参数不能通过训练自动学习,而是需要我们根据人为经验和实验来调整,或通过一些优化方法来选择。

▲ 用户指导手册

换句话说,超参数就像是模型的“指导手册”,告诉模型如何学习和优化。

02

常见超参数的解读

/ Deep Learning

超参数的选择对模型的收敛速度、泛化能力和最终效果有着至关重要的影响。

▲ 超参数的选择

下面将详细介绍常见的超参数及其作用,帮助你更好地理解和调整它们。

学习率

/ Deep Learning

学习率(Learning Rate)是深度学习中最关键的超参数之一,它决定了模型在训练过程中参数更新的步长。如果学习率过大,模型可能会像一个失控的火车,无法收敛甚至发散;而如果学习率过小,模型就会像一个行动迟缓的蜗牛,训练过程变得非常缓慢,甚至可能陷入局部最优解。🎏 作用:控制参数更新的速度。

🎏 常见选择:通常从较小的值(如0.01、0.001)尝试开始,并根据训练过程中的表现进行调整。

批次大小

/ Deep Learning

批次大小(Batch Size)是指每次训练时输入模型的数据样本数量。它直接影响模型的训练效率和内存占用。如果批次大小过大,虽然可以加快训练速度,但可能会导致模型泛化能力下降;而如果批次大小过小,模型的训练过程可能会变得不稳定。🎏 作用:平衡训练速度和内存使用。

🎏 常见选择:常见的批次大小有32、64、128等。

迭代次数

/ Deep Learning

迭代次数(Epochs) 是指整个训练数据集被完整遍历的次数。通常,训练需要进行多个迭代,直到模型收敛。🎏 作用:控制训练的总时长。🎏 常见选择:根据数据集大小和模型复杂度,通常从几十次到几百次不等。

优化器

/ Deep Learning

优化器(Optimizer)用于更新模型的参数,以最小化损失函数。不同的优化器有不同的更新策略。🎏 作用:选择合适的优化器可以加速模型收敛并提高性能。🎏 常见优化器:

- SGD(随机梯度下降):最基础的优化器,更新简单,但容易陷入局部最优。

- Adam:结合了动量和自适应学习率的优点,适合大多数任务。

- RMSprop:适合处理非平稳目标,常用于深度学习中的循环神经网络。

正则化参数

/ Deep Learning

正则化参数(Regularization Parameters)用于防止模型过拟合,常见的正则化方法包括L1正则化、L2正则化和Dropout。🎏 作用:通过限制模型复杂度,提高模型的泛化能力。🎏 常见选择:L2正则化的参数(如λ)通常从较小的值(如0.001、0.01)开始尝试。

隐藏层大小

/ Deep Learning

在神经网络中,隐藏层(Hidden Layer Size)的大小决定了模型的容量和复杂度。🎏 作用:控制模型的表达能力。🎏 常见选择:对于简单的任务,隐藏层可以较小;对于复杂的任务,可能需要较大的隐藏层。

激活函数

/ Deep Learning

激活函数(Activation Function)用于引入非线性,使神经网络能够学习复杂的映射关系。🎏 作用:引入非线性,使模型能够学习复杂的函数。🎏 常见激活函数:

- ReLU(Rectified Linear Unit):最常用的激活函数,计算简单,能有效缓解梯度消失问题。

- Sigmoid:输出范围在(0,1)之间,常用于二分类任务的输出层。

- Tanh:输出范围在(-1,1)之间,比Sigmoid更常用。

学习率衰减

/ Deep Learning

学习率衰减(Learning Rate Decay)是指在训练过程中逐渐减小学习率,以提高模型的收敛性能。🎏 作用:在训练初期使用较大的学习率快速收敛,在训练后期减小学习率以微调模型。🎏 常见策略:

- 固定衰减:每隔一定迭代次数减小学习率。

- 指数衰减:率学习按指数规律衰减。

03

超参数优化的策略

/ Deep Learning

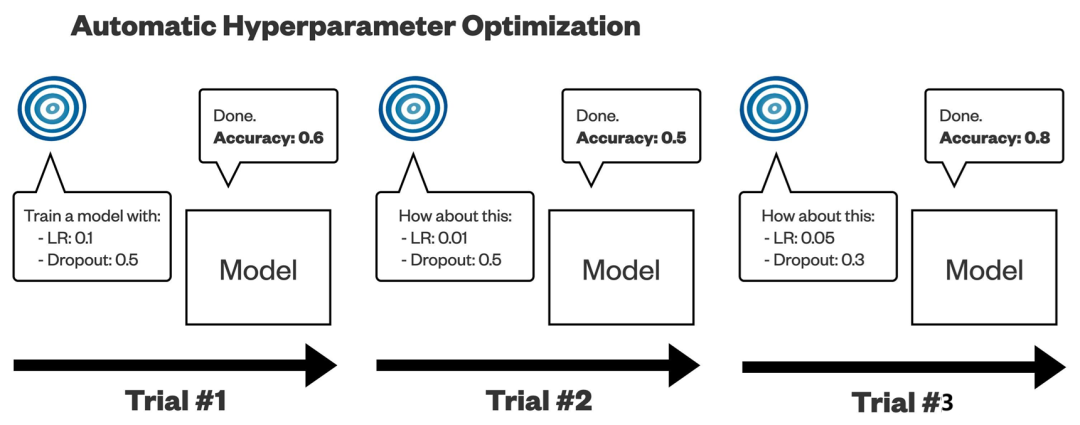

超参数优化的目标是找到一组最优的超参数组合,以最大化模型在验证集上的性能。常见的优化方法包括网格搜索(Grid Search)、随机搜索(Random Search)和贝叶斯优化(Bayesian Optimization)。

网格搜索法

网格搜索(Grid Search)是一种穷举所有超参数组合的方法。虽然这种方法可以找到最优的超参数组合,但它的缺点是计算成本非常高,尤其是当超参数较多时。

随机搜索法

随机搜索(Random Search)是通过随机选择超参数组合来进行优化。这种方法比网格搜索更高效,因为它不需要穷举所有可能的组合,但仍然有可能找到较好的超参数组合。

贝叶斯优化

贝叶斯优化是一种基于概率模型的优化方法。它通过建立超参数和模型性能之间的概率关系,逐步优化超参数的选择。这种方法在实践中被证明是非常有效的。

结 语

超参数是深度学习中不可或缺的部分,合理选择和调整超参数能够显著提升模型的性能和训练效率。虽然手动调整超参数可能比较困难,但通过使用一些优化策略,如网格搜索、随机搜索和贝叶斯优化,我们可以更高效地找到适合模型的超参数组合。

来源:Fairy Girl

发评论,每天都得现金奖励!超多礼品等你来拿

登录 后,在评论区留言并审核通过后,即可获得现金奖励,奖励规则可见: 查看奖励规则